Temario Oposiciones: Informática, concepto, evolución y fundamentos

¿Os habéis planteado alguna vez opositar para un puesto de Informática? Intentaré subir de vez en cuando, algún temario que me parezca interesante sobre temas de oposiciones actuales o pasadas…en este caso, vamos a documentar el temario de una oposición de informática de Nivel C (Oficial Técnico en Sistemas Informático). De tal forma, que podamos hacer un resumen de cada tema, para poder estudiarlo pre-oposiciones (Esto no quiere decir que, aunque intento sacarlo de fuentes de ciertos prestigio, esté bien al cien por cien). Empezamos…os pongo un ejemplo de un temario que he encontrado:

- TEMA 8. Informática: Concepto y evolución histórica. Fundamentos de teoría de la información: Representación y comunicación de la información.

Informática: Concepto y evolución histórica

¿Qué es la informática? El concepto de informática se definiría como la ciencia que se ocupa de estudiar los métodos técnicos y los procesos con el fin de almacenarlos, procesarlos y transmitir esos datos digitalmente.

Dentro de la informática actual, tendremos diferentes elementos, como software, programación, electrónica y computación.

Evolución histórica de la Informática

Ahora mismo, se nos hace extraño que en cualquier domicilio no exista un ordenador personal, teléfono inteligente o tablet, pero no hace demasiado tiempo, esto era una auténtica utopía.

La historia, al menos lo que hoy entendemos por ordenador, comienza poco antes de la mitad del siglo XX, y como veréis, participaron tanto hombres como mujeres de una capacidad intelectual extraordinaria.

Os voy a intentar resumir los hechos históricos más importantes (me centraré en el concepto de ordenador como lo conocemos ahora), que llevaron a que actualmente prácticamente todo el mundo disponga de un ordenador personal, en mi opinión, un hecho histórico tan importante como la invención de la rueda o la escritura:

- Los precursores del concepto actual de informática, fueron dos matemáticos, Charles Babbage (inglés, Cambridge) y su colaboradora Ada Byron (que no la nombran en muchos sitios, y creo que fue de gran importancia en la historia). Charles inventó la “máquina analítica”, que aunque no llegó a terminar de construirla, fue anunciada en 1834, y era capaz de almacenar 1000 números de 50 dígitos cada uno (calculaba la sucesión conocida como números de Bernoulli). Por su parte, Ada Byron, en 1843, diseñó el primer programa publicado para dicha “máquina analítica”. Esto posibilitó que Ada pensara sobre sus posibilidades y llegara a algunas conclusiones más allá del procesamiento aritmético de números, razonando que podría manipular cualquier tipo de información que se expresara mediante símbolos, como ocurre hoy en día con la música, la fotografía, el vídeo, etcétera. Además, dentro de lo que denominamos inteligencia artificial, apuntó que la máquina no podría pensar o razonar del mismo modo que lo hacemos las personas porque era incapaz de producir nada nuevo más allá de aquello para lo que estuviera programada.

- Unos años después, al principio del siglo XX, con el comienzo de la Segunda Guerra Mundial 1939-1945 (a veces las guerras traen cosas buenas o hacen que el ser humano intente superarse para sobrevivir), y gracias a los avances en la electrónica, el gobierno inglés, por ejemplo, invirtió grandes esfuerzos en la construcción de una

serie de máquinas electrónicas para descifrar los mensajes que la marina alemana codificaba mediante la conocida máquina “Enigma”. Con la participación de varios matemáticos de renombre (Alan Turing o Max Newman), se crearon bajo secretismo militar en 1943, las máquinas “Colossus” bajo las órdenes del ingeniero “Thomas H. Flowers”. Tal era el secreto, que se ordenó destruirlas… - Fue, sin embargo, en Estados Unidos, donde el esfuerzo bélico llevó a la construcción del ENIAC (Electronic Numerical Integrator And Computer), una impresionante máquina electrónica diseñada para calcular trayectorias balísticas y en torno a la cual se establecieron las bases de lo que hoy en día entendemos por un ordenador. La construcción, financiada por el ejército norteamericano pero llevada a cabo en el ámbito académico, fue llevada a cabo en secreto por un equipo dirigido por John Mauchly, físico responsable del diseño conceptual, y John P. Eckert, ingeniero de una gran capacidad responsable del diseño de los circuitos electrónicos. ENIAC pesaba unas 30 toneladas y desprendía muchísimo calor. Finalmente, fue un equipo de seis mujeres graduadas en matemáticas y lógica, las ENIAC girls, que ya trabajaban como computers para el ejército, quienes lidiaron con la programación a partir únicamente de los esquemas de conexión y las aclaraciones proporcionadas por los propios ingenieros (la programación de ordenadores fue considerada una tarea eminentemente femenina, hasta finales de los años 60, aunque los que nos dedicamos a la informática, sabemos que ha durado bastante más 🙂 )

- ENIAC tenía ciertas limitaciones en cuanto a memoria y versatilidad en su programación. De la necesidad de mejorar estas debilidades, surge lo que hoy conocemos el concepto de programa almacenado. En septiembre de 1944, cuando John von Neumann (1903-1957), un científico de enorme prestigio involucrado en el proyecto Manhattan, se incorporó como colaborador en el equipo del ENIAC. El proyecto Manhattan intentaba entonces construir las bombas atómicas que se arrojarían sobre la población civil japonesa en agosto de 1945 y von Neumann necesitaba una máquina capaz de resolver los complicados modelos matemáticos que usaban en su diseño (de ahí surgió EDVAC (Electronic Discrete Variable Automatic Computer)). En muy poco tiempo, John von Neumann, dotado de una capacidad matemática excepcional, fue capaz de sintetizar de una forma asombrosamente clara y lógica el principio de programa almacenado.

- Existen otras fechas que nos hicieron llegar a la informática actual:

- En 1954 IBM presenta la primera calculadora de bolsillo, creada con transistores.

- 1969, el departamento de defensa de Estados Unidos, crea una red de computadoras entre los diferentes organismos del gobierno llamada ARPANET, que fue la precursora de lo que hoy conocemos como INTERNET.

- En 1971, el programador informático Ray Tomlinson, logra enviar el primer email de la historia (sin respuesta, por cierto)

- 1981, IBM lanza el primer PC o ordenador personal de la historia, pasando de ser algo vetado a los Gobiernos a ser de uso general (no eran baratos)

- 1990, el científico británico Tim Berners-Lee, genera la primera página web de la historia (os dejo el enlace: http://info.cern.ch/hypertext/WWW/TheProject.html)

- A partir de estas fechas, todo es historia actual, el primer ordenador de Apple en 1976, la creación de Google en 1998, el primer sistema operativo Windows de la mano de Microsoft en 1979 (llamado Xenix), Office en 1989, Windows 3.0 en 1990…

Fundamentos de teoría de la información: Representación y comunicación de la información

Para que un ordenador ejecute un programa, es necesario darle dos tipos de datos básicos:

- Instrucciones que forman el programa

- Datos para que esas instrucciones nos devuelvan un resultado

Esto pasa en la comunicación entre humanos, hay un emisor y un receptor que recibe la información, procesa ese mensaje, y genera una reacción. Con los ordenadores es muy parecido, pero tienen que tener los datos cargados en el programa para darnos un resultado.

Ahora bien, ¿Cómo se representan? De eso vamos a hablar a continuación, el humano introduce caracteres de su alfabeto para interactuar con el programa:

- Caracteres alfabéticos: Son las letras mayúsculas y minúsculas del abecedario inglés (A,B,C,D…a,b,c…x,y,z)

- Caracteres numéricos: Las diez cifras decimales (0, 1, 2,..,9)

- Caracteres especiales: Los caracteres no incluidos anteriormente (,*/;:Ññ=<>#…)

- Caracteres de control: Son órdenes de control, como un indicador de fin de línea

- Caracteres gráficos: Son símbolos con los que se pueden representar figuras fundamentales

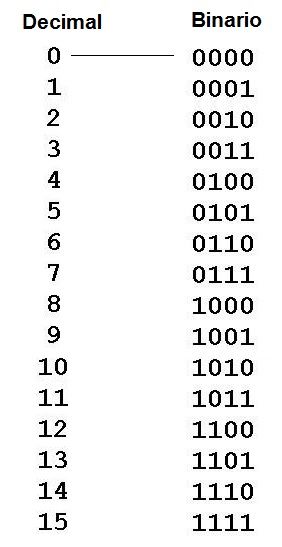

Los ordenadores, efectúan operaciones aritméticas utilizando una representación para los datos numéricos, basada en el sistema de numeración en base dos o binario natural. Los famosos 1 (unos) y 0 (ceros), o cifras binarias o bits. Cada número en binario, tiene su equivalente en decimal y viceversa, de la siguiente forma:

Ahora bien, cómo hacemos estas migraciones de una forma fácil para extraer un número. Fuente:

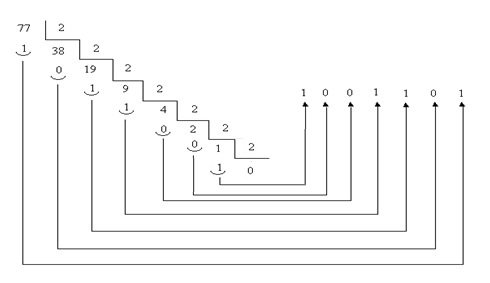

- Conversión de un número de decimal a binario: Para averiguar cómo codificaría un ordenador un número que está expresado en el “sistema decimal” habrá que dividir dicho número consecutivamente entre 2, hasta que no sea posible la división, y quedarse con los restos de todas las divisiones empleadas en orden inverso, así por ejemplo el número 77 un ordenador lo representaría como 100101:

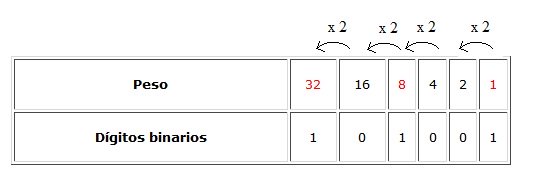

- Conversión de un número de binario a decimal: El paso contrario puede hacerse mediante el método de los pesos, consistente en asociar al dígito binario situado más a la derecha el peso 1, el que le sigue a su izquierda el peso 2, el siguiente 4 y así vamos doblando el peso de los restantes con respecto al que tienen a su derecha. Una vez asignados todos los pesos sumamos solamente aquellos en que corresponden a aquellos dígitos binarios de valor 1. Veámoslo con el siguiente ejemplo, imaginemos que queremos convertir el número binario 101001 a decimal:

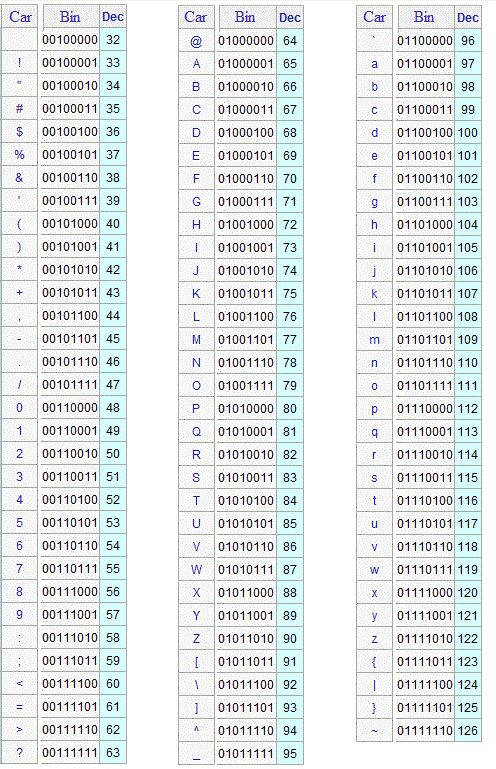

Al conjunto de caracteres que puede representar el ordenador junto con su código binario asignado se le llama código de caracteres, uno de los primeros en utilizarse fue el código ASCII (American Standard Code for Information Interchange) y usa una secuencia de 8 dígitos binarios o bits para cada caracteres. Quedaría de la siguiente forma tanto para el resto de caracteres (la tabla completa de códigos ASCII dispone de 256 caracteres):

¿Cómo se guarda esa información para ser gestionada por un ordenador? Os dejo alguna pregunta que he encontrado de ejemplo, ya veis que muchas veces hay que saber la teoría para poder aplicar en la respuesta:

- Los discos duros son dispositivos de almacenamiento donde los ceros y unos se guardan en forma de cargas magnéticas

- Los ceros y unos se guardan en los CD´s o DVD´s en forma de microscópicos valles y cumbres en la superficie, que se leen mediante un láser

- En las memorias RAM los ceros y unos se guardan en transistores o condensadores, que son minúsculas baterías que pueden estar cargadas con un voltaje bajo o normal

Consejo de novato en oposiciones:

- Nunca contestéis una pregunta que te cueste un negativo si no tienes ni idea de qué os hablan (lección aprendida en mi primera oposición, pasas de suspender a sacar notaza jeje!! )

¿Te ha gustado la entrada SÍGUENOS EN TWITTER O INVITANOS A UN CAFE?

Blog Virtualizacion Tu Blog de Virtualización en Español. Maquinas Virtuales (El Blog de Negu) en castellano. Blog informática vExpert Raul Unzue

Blog Virtualizacion Tu Blog de Virtualización en Español. Maquinas Virtuales (El Blog de Negu) en castellano. Blog informática vExpert Raul Unzue