Proxmox: eliminar storage cluster CephFS

Hoy voy a mostraros como eliminar vuestra configuración de Proxmox en un storage o almacenamiento CephFS ya implementado.

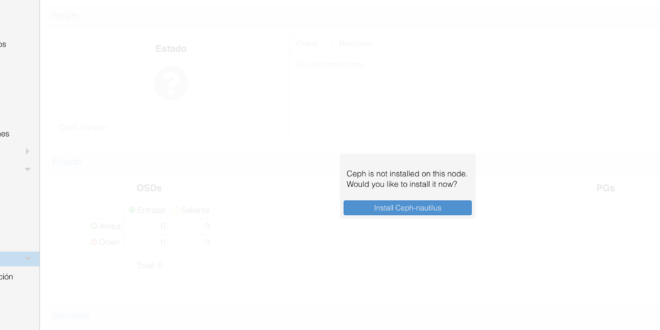

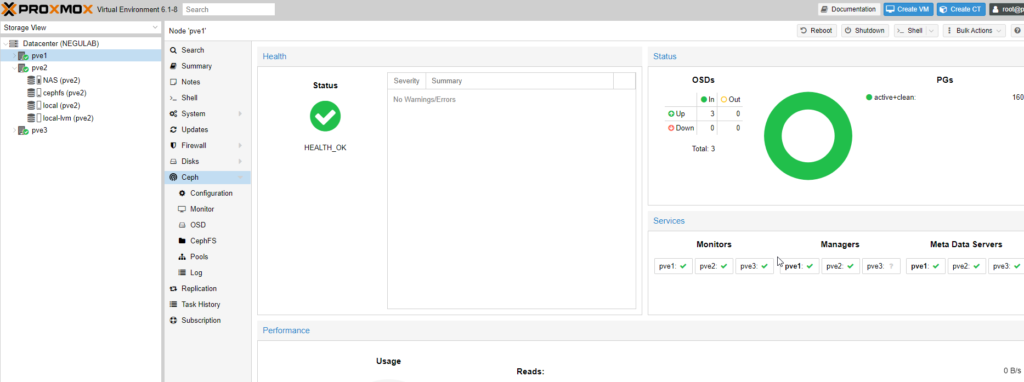

Como os muestro en la imagen, todo está correcto, tengo 3 nodos y varios discos implementados. Todo OK, pero como los LABS son para aprender, os enseño como se desmonta:

Lo intenté vía gráfica, pero realmente, es tan tedioso, que el procedimiento es mejor hacerlo vía comando para que sea más limpio y más rápido.

Este procedimiento que voy a contar elimina los datos de los discos y toda configuración de CEPH, que ese es mi objetivo final, seguro que se puede desmontar sin perder datos (la forma gráfica seguro que para esto es mejor), pero no es algo que necesite en este caso.

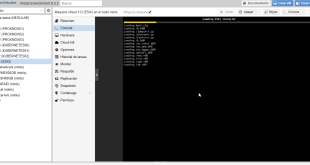

Comandos que vamos a lanzar desde cada nodo:

## Paramos todos los servicios de CEPH

root@pve2:~# systemctl stop ceph-mon.target

root@pve2:~# systemctl stop ceph-mgr.target

root@pve2:~# systemctl stop ceph-mds.target

root@pve2:~# systemctl stop ceph-osd.target

# Para evitar que se arranquen en el siguiente reinicio, lanzamos:

root@pve2:~# rm -rf /etc/systemd/system/ceph*

## Nos aseguramos realmente que están parados (que ya deberían estar):

root@pve2:~# killall -9 ceph-mon ceph-mgr ceph-mds

## Eliminamos todos los rastros:

root@pve2:~# rm -rf /var/lib/ceph/mon/ /var/lib/ceph/mgr/ /var/lib/ceph/mds/ /var/lib/ceph/osd/ /etc/pve/ceph.conf /etc/ceph/ceph.conf

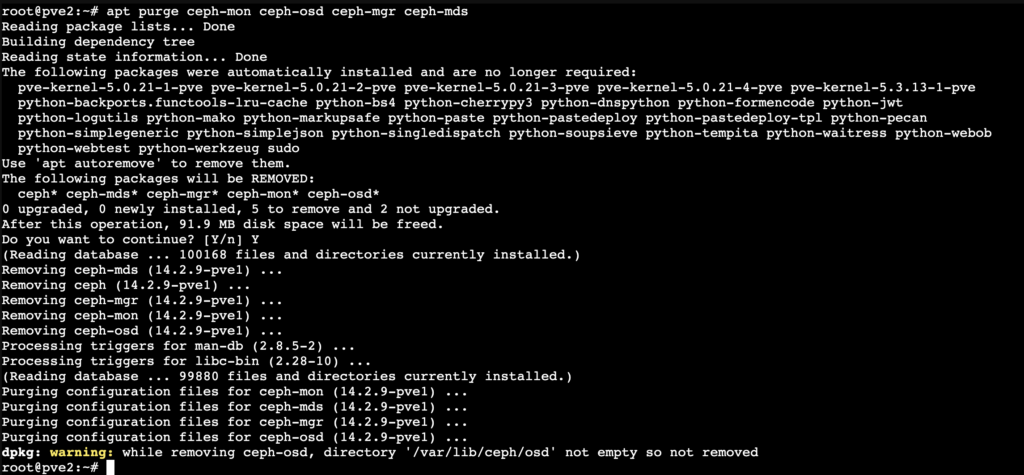

## Y hacemos una purga del servidor:

root@pve2:~# pveceph purge

## Y luego la purga completa:

root@pve2:~# apt purge ceph-mon ceph-osd ceph-mgr ceph-mds

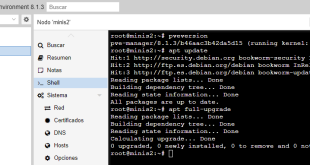

Reading package lists… Done

Building dependency tree

Reading state information… Done

Package ‘ceph-mds’ is not installed, so not removed

Package ‘ceph-mgr’ is not installed, so not removed

Package ‘ceph-mon’ is not installed, so not removed

Package ‘ceph-osd’ is not installed, so not removed

The following packages were automatically installed and are no longer required:

pve-kernel-5.0.21-1-pve pve-kernel-5.0.21-2-pve pve-kernel-5.0.21-3-pve pve-kernel-5.0.21-4-pve pve-kernel-5.3.13-1-pve

python-backports.functools-lru-cache python-bs4 python-cherrypy3 python-dnspython python-formencode python-jwt

python-logutils python-mako python-markupsafe python-paste python-pastedeploy python-pastedeploy-tpl python-pecan

python-simplegeneric python-simplejson python-singledispatch python-soupsieve python-tempita python-waitress python-webob

python-webtest python-werkzeug sudo

Use ‘apt autoremove’ to remove them.

0 upgraded, 0 newly installed, 0 to remove and 2 not upgraded.

Comprobar adicionalmente si se han quedado carpetas en /mnt/pve/ o /var/lib/ceph (para eliminar el contenido se necesita reinicio del host)

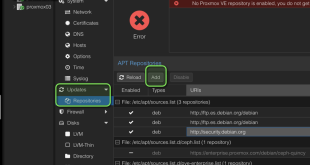

Si seguís teniendo algún problema podéis optar por:

- apt-get purge ceph

- apt-get autoremove –purge ceph

En varias pruebas me he encontrado errores 500, y se reparaban eliminando los ficheros perm:

|

1 2 3 4 |

root@pve3:/var/lib/dpkg/info# ls -l ce*.prerm -rwxr-xr-x 1 root root 715 Apr 15 11:26 ceph-base.prerm -rwxr-xr-x 1 root root 235 Apr 15 11:26 ceph-common.prerm -rwxr-xr-x 1 root root 223 Apr 15 11:26 ceph-fuse.prerm |

Adicionalmente, he formateado los discos con fdisk para poder volver a reutilizarlos.

- fdisk /dev/sdc

- Opción g

- Opción w

Podemos usar también ceph-volume lvm zap /dev/sdc

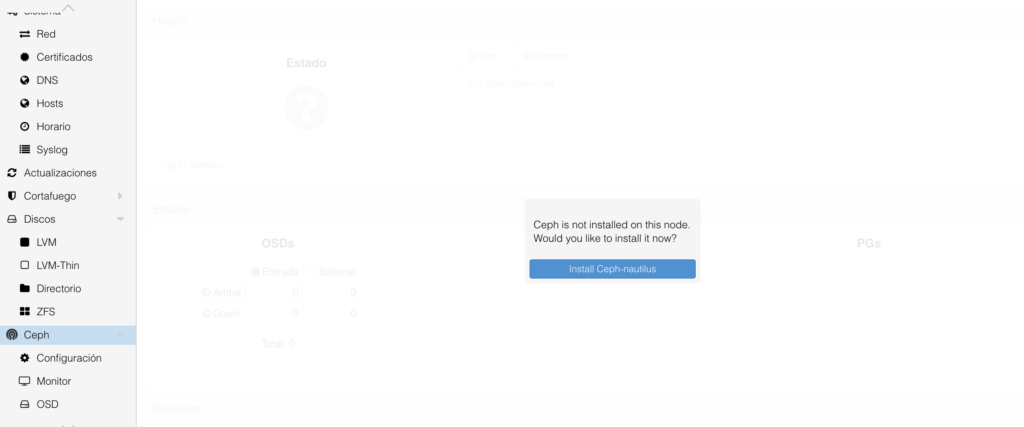

Una vez tengamos estos pasos terminados, nos encontraremos ya con CephFS como la primera vez que lo intentamos configurar:

¿Te ha gustado la entrada SÍGUENOS EN TWITTER?

¿Te ha gustado la entrada SÍGUENOS EN TWITTER O INVITANOS A UN CAFE?

Blog Virtualizacion Tu Blog de Virtualización en Español. Maquinas Virtuales (El Blog de Negu) en castellano. Blog informática vExpert Raul Unzue

Blog Virtualizacion Tu Blog de Virtualización en Español. Maquinas Virtuales (El Blog de Negu) en castellano. Blog informática vExpert Raul Unzue